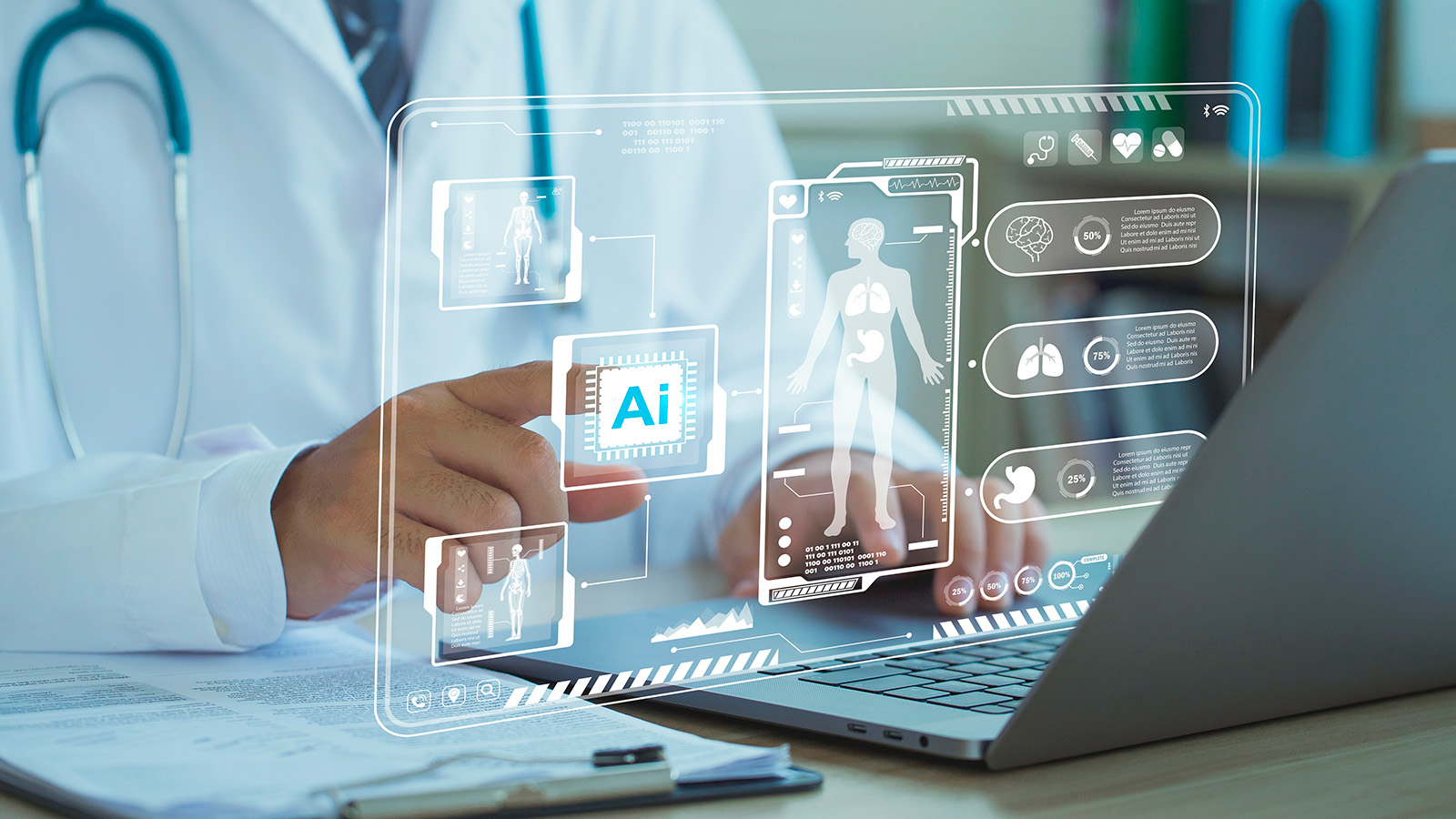

ChatGPT превзошел врачей-стажеров в диагностике респираторных заболеваний

. Он смог выявить муковисцидоз, астму и инфекции грудной клеткиMedical Xpress: ChatGPT превзошел врачей-стажеров в диагностике заболеваний

ChatGPT превзошел врачей-стажеров в диагностике заболеваний

Чат-бот ChatGPT превзошел врачей-стажеров в диагностике сложных респираторных заболеваний у детей. Искусственный интеллект смог более качественно выявлять клинические случаи, связанные с такими заболеваниями, как муковисцидоз, астма и инфекции грудной клетки. Об этом сообщает портал Medical Xpress. Исследование было представлено в рамках Конгресса Европейского респираторного общества (European Respiratory Society Congress) в Вене.

Результаты исследования представил доктор Манджит Нараянан (Manjith Narayanan) из Королевской больницы для детей и молодежи (Royal Hospital for Children and Young People) в Эдинбурге. Для тестирования были использованы клинические сценарии, часто встречающиеся в детской медицине. Сценарии требовали глубокого анализа — эксперты составили их таким образом, что поставить однозначный диагноз или дать стандартные медицинские рекомендации для них было невозможно.

В исследовании приняли участие десять врачей-стажеров с опытом работы в педиатрии менее четырех месяцев. Им было дано задание проанализировать эти сценарии и поставить диагноз, используя только интернет-ресурсы. Точно такая же задача стояла и перед чат-ботами. Ответы оценивались группой экспертов.

Искусственный интеллект смог более качественно выявлять клинические случаи, связанные с такими заболеваниями, как муковисцидоз, астма и инфекции грудной клетки

ChatGPT 3.5 получил самую высокую среднюю оценку — семь баллов из девяти, его ответы показались экспертам наиболее «гуманными». Google Bard (в феврале 2024 года переименован в Gemini) набрал шесть баллов, а Microsoft Bing получил такую же оценку, как и стажеры, — четыре балла. При этом ответы чат-ботов от Google и Microsoft эксперты легко опознали как сгенерированные нейросетью.

Доктор Нараянан отметил, что это первое исследование, в котором большие языковые модели (LLM) тестируются на врачах-стажерах в условиях, максимально приближенных к реальной практике.

Также было отмечено, что ни один из чат-ботов не продемонстрировал «галлюцинаций» — вымышленных данных. Однако исследователи подчеркивают, что это потенциальный риск, о котором необходимо помнить, прежде чем внедрять искусственный интеллект в клиническую практику.

«Искусственный интеллект открывает новые возможности в медицине, но перед его внедрением в повседневную практику важно тщательно проверить его точность и безопасность. Нам нужно также оценить, насколько эффективно он впишется в работу организаций, и разобраться, какие последствия это может иметь для общества», — отметила профессор Эдинбургского университета Хилари Пиннок (Hilary Pinnock), не принимавшая участия в исследовании.

Ранее исследователи выяснили, что искусственный интеллект оказался хуже людей-сотрудников. В рамках исследования ИИ было поручено обобщить правительственные документы и написать резюме. Результаты оценки показали, что резюме, созданные ИИ, набрали всего 47%. А резюме реальных сотрудников набрали 81%. Искусственный интеллект не смог предоставить точные номера страниц, откуда были взяты данные. Помимо этого, оказалось, что ИИ не способен уловить контекст и нюансы — в итоге в документ было включено много несущественных деталей.