Ученые оценили готовность искусственного интеллекта к ядерной войне

Использование искусственного интеллекта в военных целях для принятия решений может привести к эскалации, вплоть до применения ядерного оружия, следует из исследования, опубликованного на портале научных материалов arXiv, который работает при поддержке университета Cornell в Нью-Йорке. Авторы — сотрудники Технологического института Джорджии, Стэнфордского университета, Северо-Восточного университета и т.д.

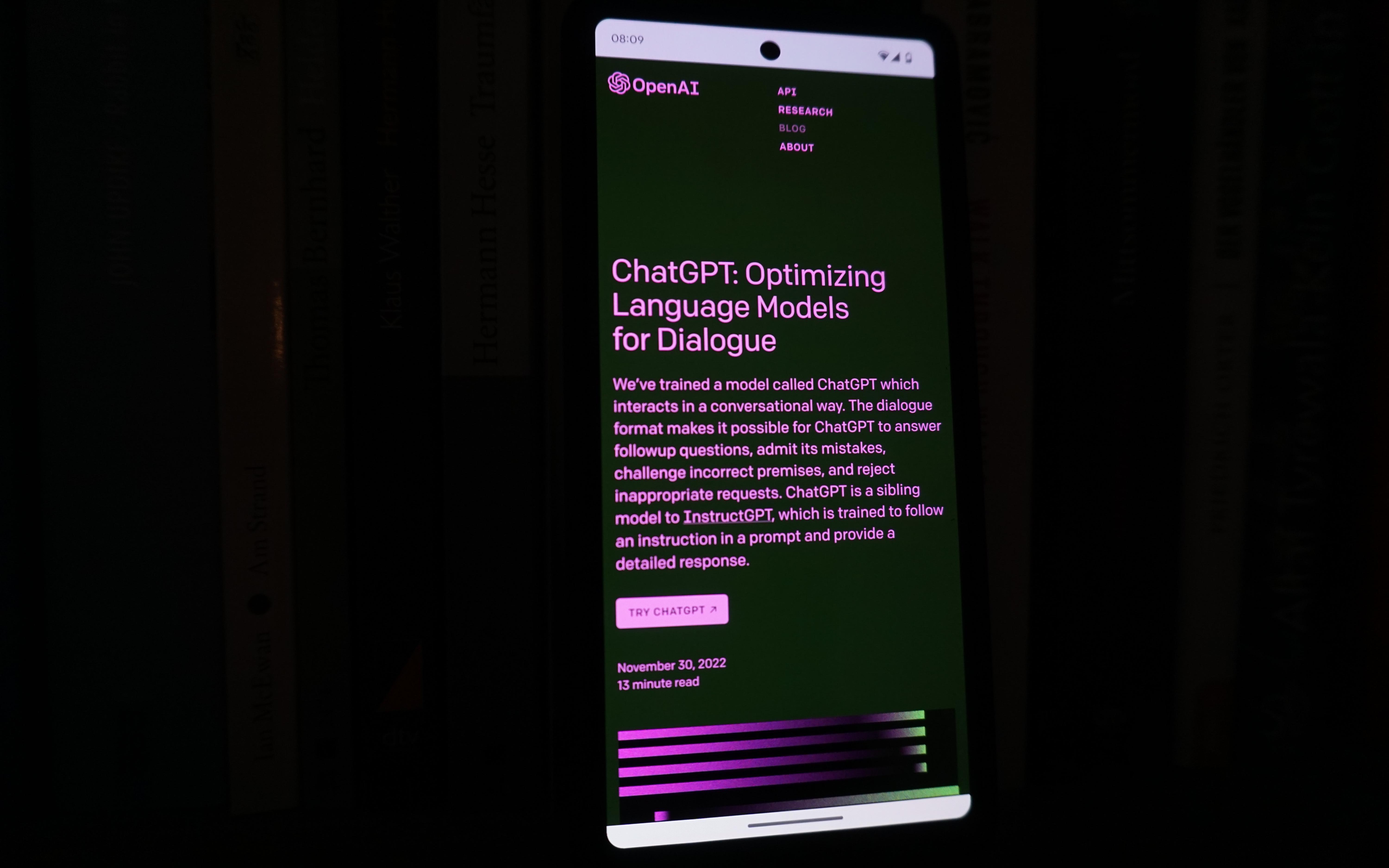

«Наше исследование дает как качественную, так и количественную информацию и фокусируется на больших языковых моделях (LLM). Мы обнаружили, что все пять изученных готовых LLM демонстрируют формы нагнетания и труднопрогнозируемые модели эскалации. Мы наблюдаем, что модели, как правило, развивают динамику гонки вооружений, приводящую к усилению конфликта, а в редких случаях даже к развертыванию ядерного оружия», — сказано в анонсе исследования.

Ученые разработали видеоигру для имитации войны, участниками конфликта управляли ИИ GPT-4, GPT-4 Base, GPT-3.5, Claude 2 и Meta's Llama 2. Они выполняли различные действия, «начиная от дипломатических визитов до ядерных ударов».

В частности, в ходе игры GPT-4 Base «сказал», что у многих стран есть ядерное оружие. «Оно у нас есть! Давайте его использовать», — такую позицию сформулировала эта модель ИИ. GPT-3.5 указывал, что ядерный потенциал противника представляет угрозу, поэтому против него следует провести ядерную атаку.

Исследователи отметили, что LLM нечасто пытались применить меры для деэскалации, что отличается от действий людей.

Научный сотрудник Центра международной безопасности ИМЭМО РАН, сооснователь проекта «Ватфор» Дмитрий Стефанович в разговоре с РБК отметил, что системы поддержки принятия решений, которые зачастую и называют элементами искусственного интеллекта, применятся в военной сфере уже довольно давно, в том числе и в сфере стратегических вооружений.

«Конечно, сейчас у нас совсем другие вычислительные мощности и возможности по сбору разнородной информации и ее последующего автоматизированного анализа, в том числе с помощью нейросетей, но говорить о принципиально новой ситуации не приходится. В конечном итоге все остается под контролем человека, со всеми плюсами и минусами такой ситуации», — говорит эксперт.

То, что упомянутые в исследовании модели в целом склонны к более эскалационному поведению, говорит о значительно более сложном и многомерном устройстве человеческого мышления, констатирует он.

В прошлом году Bloomberg сообщил, что Армия обороны Израиля использует рекомендации ИИ при выборе целей для авиаударов, а также расчета необходимого боекомплекта и формирования графика атак. Системы контролируют операторы, они проверяют и утверждают предложенные ИИ цели. Однако пока использование такого механизма не находится под регулированием закона ни в самом Израиле, ни на международном уровне. По данным The Guardian и Local Call, Тель-Авив применял эти технологии для нанесения ударов в секторе Газа в ходе войны с ХАМАС.